Real-MedNLP

近年,医療記録が紙に代わって電子化されることが多くなり,医療分野における情報処理技術の重要性が高まっています.しかし,日本語や中国語をはじめとした非英語圏では匿名化された医療テキストデータがまだ多くありません.私たちはこのような状況で,4つの医療自然言語処理 (MedNLP) タスク(MedNLP-1, MedNLP-2, MedNLPDoc, MedWeb)を提案してきました.今回はさらにMedNLPを実現可能な技術に昇華するため,Real-MedNLPを提案します.

NEWS

このワークショップについて

Real-MedNLPは実際の医療文書(症例報告,読影所見)を用いた医療言語処理シェアードタスク・ワークショップです.

本タスクが様々な医療サービスを支援する実用システムの開発を促進することを目指します.

Real-MedNLPタスクには2 種類のコーパス に基づくトラック(MedTxt-CR Track, MedTxt-RR Track)があり,それぞれ3つのサブタスクから構成されます.

データセット

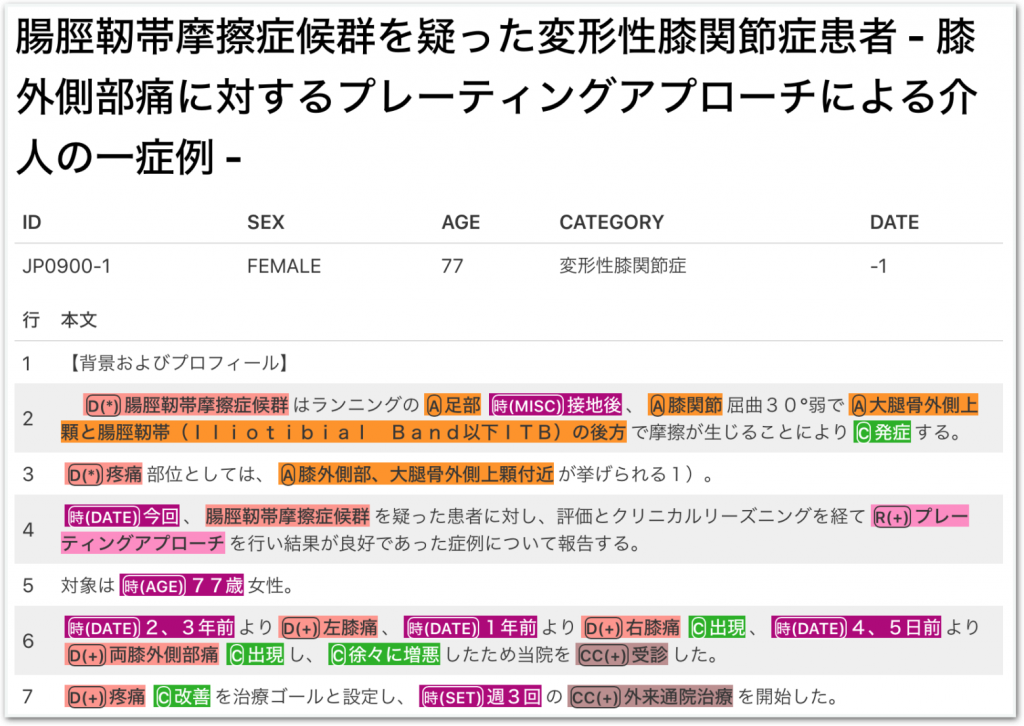

MedTxt-CRコーパス

CiNiiで公開されているオープンアクセスの症例報告のデータセットです.出版物をオープンアクセスにする医学会の数は限られています.各医学会の出版方針による偏りをなくすため,実際の患者や疾患の頻度に基づいて症例報告を選択しました.

- トレーニングセット:100文書

- テストセット:100文書

症例報告とは,患者のために書かれた医学研究論文の一種です.症例報告は症例の経過または対象疾患の歴史のほとんどをカバーしており,各医学会には通常、症例報告の提出トラックがあるため,症例報告の数は他の論文よりも多くなっています.これらの利点を考慮すると,症例報告は有望な情報リソースであると言えます.さらに,症例報告の形式は医療報告書の一種である退院サマリーの形式と類似しているため,症例報告分析の手法は退院サマリー分析に拡張することができます.

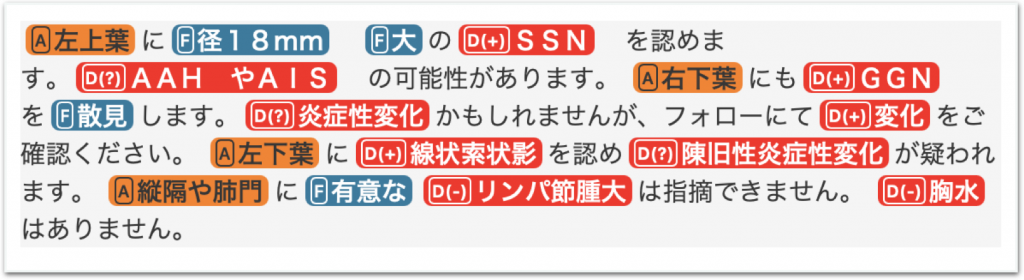

MedTxt-RRコーパス

肺癌CT画像15症例に対し,それぞれに9 人の放射線科医が作成した合計135件の読影所見のデータセットです.

- トレーニングセット:72文書

- テストセット:63文書

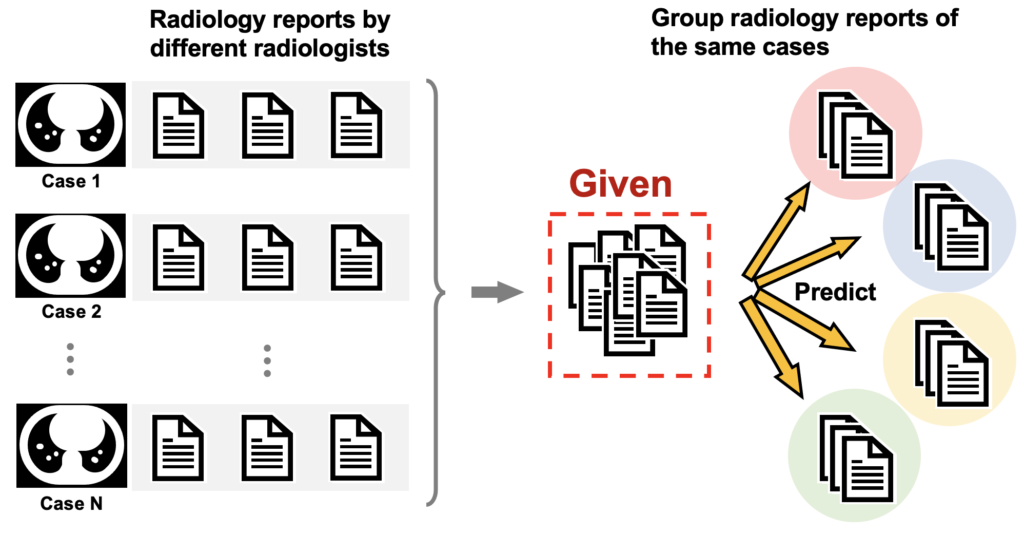

読影所見とは,放射線科医によって書かれた一種の臨床文書です.基本的には1枚のレントゲン画像に着目し,その画像から予想される所見をすべて記載します.読影所見を分析する際の最大の問題の 1 つとして,表現が多様な一方で,通常は 1 つの画像に対して 1 つの報告しか作成されないため,特定の医療機関からの報告を集めるだけでは,同じ診断に対してどのように文章を書くのかを十分に理解できない点でした.本タスクでは,この問題を解決するために,複数人の医師が同一画像に対して個別に所見を執筆することで,多様な表現を含む所見データを構築しました.

タスク概要

少ないリソースでの固有表現抽出 (Named Entity Recognition; NER)

医療言語処理においてデファクトスタンダードなサイズとなっている100∼200文書程度のコーパスを用いた,医療言語処理の最も基本的な情報抽出であるNERに関するサブタスクです.

サブタスク 1:100程度の極めて小規模なサンプルでのNER

- 72文書からなるトレーニングセットを用いたNER

- 標準的な少ないリソースでの教師付き学習に相当

サブタスク 2:ガイドラインを用いたNER

- アノテーション・ガイドラインにおける各タグについての例文を用いたNER

- アノテーション・ガイドラインから学ぶことが多い人間のアノテーターのトレーニングを模擬

<article id="JP0217-29" title="著明な好酸球増多を伴った非昏睡型急性肝不全の一例"> 【症例】<TIMEX3 type="AGE">53歳</TIMEX3>女性 【主訴】<d certainty="positive">発熱</d> 【経過】<TIMEX3 type="DATE">X-2年</TIMEX3>に<d certainty="positive">皮疹</d>を契機に当院皮膚科を<cc state="executed">受診</cc>し,<d certainty="positive">水泡性類天庖瘡</d>と診断された. <m-key state="executed">プレドニゾロン (PSL)</m-key> <m-val>1mg/kg/day</m-val>を導入され,<TIMEX3 type="TIME">以降</TIMEX3><m-key state="executed">免疫調整薬</m-key>を併用し,<m-key state="executed">PSL</m-key><c>漸減</c>の上で管理されていた. <TIMEX3 type="DATE">X年8月</TIMEX3>に<m-key state="executed">PSL</m-key><m-val>6mg/day</m-val>まで<c>減量</c>した時点で<m-key state="negated">PSL</m-key>を自己中断されたが<d certainty="negative">皮疹の増悪</d>は認められなかった. <TIMEX3 type="DATE">9月9日</TIMEX3>より<d certainty="positive">倦怠感</d>を自覚,<TIMEX3 type="DATE">10日</TIMEX3>に<f>38℃</f>の<d certainty="positive">発熱</d>が<c>出現</c>したため,当院を<cc state="executed">受診</cc>した. ...(後略)... </article>

2021-10-22 本ワークショップと無関係なページをアノテーションガイドラインから削除しました

2021-12-20 数カ所のアノテーションミスを修正しました

応用 (Applications)

実用的な観点からコーパストラックごとに設計された応用サブタスクです.

サブタスク 3:応用

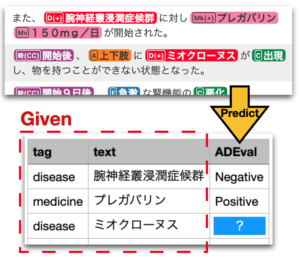

[MedTxt-CR Track] Adverse Drug Event detection (ADE)

症例報告から薬物有害事象 (ADE) 情報を抽出してテーブルを作成

[MedTxt-RR Track] Case Identification (CI)

同一症例について記載された読影所見を同定

スケジュール

データセット配布開始(参加登録チームにメールで送信)September 1,2021 December 1,2021: タスク参加登録締切September-November 2021: 予備テスト (Dry Run)※本タスクはパイロットタスクのため,予備テストは実施しないことにしましたJanuary 10-17, 2022: サブタスク 1・2 本テストJanuary 10, 2022: テストデータ公開 (the organizer to participants)January 17, 2022: テスト結果提出締切 (participants to the organizer)

January 18-25, 2022: サブタスク 3 (ADE・CI) 本テストJanuary 18, 2022: テストデータ公開 (the organizer to participants)January 25, 2022: テスト結果提出締切 (participants to the organizer)

February 1,2022: 評価結果の返送February 1,2022: タスク概要論文一部公開March 1,2022: タスク参加者論文(ドラフト) 提出締切May 1,2022: タスク参加者論文・タスク概要論文 提出最終締切- June 14-17,2022: NTCIR-16 カンファレンス(オンライン) [プログラム][参加登録]

- June 17, 2022: Real-MedNLP Session

FAQ

Subtask 1 では,参加者は配布された学習データセットを用いてモデルを教師あり学習することができます.Subtask 2では,参加者はアノテーションガイドライン中の例文を使用することができますが,Subtask 1 用に配布された学習データセットを使用することはできません.

どちらのサブタスクでも,参加者は任意の外部リソースを使用することは可能です(つまり,半教師あり学習はOK).

テストデータセットとして,タグをすべて取り除いたクリアなレポートを提供します.参加者はトレーニングデータのように,テストデータにタグを付与してください.

Subtask 1 と2では,エンティティレベルとエンティティ+属性レベル(ジョイント)の 2 レベルの評価を行う予定です.ジョイント評価では,エンティティと属性の両方が一致すれば正解とし,属性は一致するがエンティティが一致しない場合は不正解とします.エンティティの属性を取り扱うかどうかは任意ですが,実用的な観点からエンティティと属性の両方を認識することをおすすめします.

Subtask 1 と2 では,precision, recall, F1 (micro, macro) など,さまざまな評価指標を採用する予定です.詳細は後日発表いたします.

いいえ,ADEチャレンジにはNERは含まれていません.ADEチャレンジのために,タグ付きのレポートを提供します.提出ファイルでは,”articleID,” “tag,” “text” が与えられますので,”ADEval”の値を回答していただきます.

CIチャレンジはクラスタリングタスクですので,正規化相互情報量を用いる予定です.

Formal run の期間は,テストセットのリリース直後の1週間です.

3 つのsubtask のスケジュールは基本的には同じですが,Subtask 3 のADEチャレンジのテストセットに使うレポートはSubtask 1と2のNERの答えであるため,データの提供タイミングとFormal run の期間をずらします.Formal run の流れは次の通りです:Subtask 1とSubtask 2 のテストセットの提供・Formal run・結果提出(1週間)-> Subtask 3 のテストセットの提供・Formal run・結果提出 (1週間).

いいえ,Subtask 1 と2の評価では,以下のタグセットのみを対象とする予定です:

CR: <d>, <a>, <timex3>, <t-test>, <t-key>, <t-val>, <m-key>, <m-val>

RR: <d>, <a>, <timex3>, <t-test>

主催

- 荒牧 英治(奈良先端科学技術大学院)

- 若宮 翔子(奈良先端科学技術大学院)

- 矢田 竣太郎(奈良先端科学技術大学院)

- 中村 優太(東京大学)

協力

謝辞

MedTxt-RR Track とアノテーションは JST AIP-PRISMの支援を受けたものである.MedTxt-CR Track は JST AIP 日独仏AI研究のKEEPHA プロジェクト (JPMJCR20G9) の支援を受けたものである.

スポンサー募集

Real-MedNLP ではスポンサーを募集しています.Real-MedNLP に協賛にご興味のある方は,メールにてお問い合わせください.

なお,スポンサーもタスクに参加可能です.

お問い合わせ

- Real-MedNLP連絡先:real-mednlp[at]is.naist.jp